Data & IA

L’IA au service de la Business Intelligence : méthodes et cas d’usage

20 janvier 2026

10

min de lecture

Sommaire

Définitions = Business Intelligence (BI) : ensemble des méthodes, outils et processus permettant de collecter, structurer, analyser et restituer les données afin d’aider les entreprises à piloter leur activité et à prendre des décisions éclairées.

MCP Power BI (Model Context Protocol) : couche d’intermédiation permettant de fournir à une IA (via Microsoft Copilot) un contexte structuré basé sur le modèle sémantique Power BI et les règles métier formalisées. Le MCP ne prend pas de décisions : il encadre et sécurise l’intervention de l’IA.

Visual Studio Code (VS Code) : environnement de développement utilisé ici comme espace de travail central pour manipuler les fichiers d’un projet Power BI (TMDL, JSON, Markdown), versionner les évolutions et faciliter la collaboration entre data analystes et outils d’IA.

Introduction

L’IA au secours de la BI : cap sur l’industrialisation

La BI traditionnelle sature. Découvrez comment l’intelligence artificielle transforme la gestion des données : automatisation des tâches, sécurisation des règles métier et passage à une production plus agile.

Un guide signé Synako pour reprendre le contrôle sur vos données et libérer le potentiel de vos data analystes.

Depuis plusieurs années, la Business Intelligence s’est imposée comme un pilier du pilotage des entreprises. Les tableaux de bord se sont multipliés, les volumes de données ont explosé, et les attentes des métiers se sont accrues. Pourtant, dans beaucoup d’organisations, la BI reste difficile à faire évoluer : chaque modification prend du temps, les dashboards se complexifient, et la cohérence globale devient fragile à mesure que les usages grandissent.

Dans ce contexte, l’intelligence artificielle (IA) est souvent perçue comme une promesse vague ou comme un gadget réservé à des usages avancés. En réalité, utilisée correctement, l’IA ne remplace ni les analystes ni les outils existants. Elle agit comme un accélérateur, capable de fluidifier la production, d’automatiser certaines tâches répétitives et de rapprocher la BI des besoins métier.

Cet article propose un éclairage concret sur la manière dont l’IA peut aujourd’hui s’intégrer dans une démarche de Business Intelligence moderne, à travers des méthodes éprouvées et des cas d’usage opérationnels, notamment dans des environnements Power BI structurés.

Pourquoi la BI devient difficile à maintenir à mesure qu’elle grandit

Dans beaucoup d’entreprises, la Business Intelligence démarre de façon pragmatique : quelques dashboards, construits rapidement pour répondre à un besoin précis. Mais avec le temps, ces rapports s’accumulent, les règles métier évoluent, les sources de données se multiplient, et chaque modification devient plus coûteuse.

Au-delà de la complexité fonctionnelle, un problème très concret apparaît côté équipes data : les environnements BI deviennent lourds à manipuler. Les dashboards prennent du temps à charger, chaque ouverture de rapport mobilise des ressources importantes, et la moindre modification implique souvent d’attendre, de tester, puis de reproduire les changements sur plusieurs objets. Cette inertie technique consomme une part significative du temps des data analystes, avant même de pouvoir travailler sur le fond.

Le problème n’est pas l’outil en lui-même, mais la manière dont il est utilisé. Lorsqu’un environnement BI repose sur des fichiers isolés, peu versionnés et fortement dépendants de manipulations manuelles, toute évolution entraîne des risques : incohérences entre dashboards, erreurs de calcul, pertes de temps, et dépendance accrue à quelques profils clés capables de naviguer dans cette complexité.

Dans ce contexte, unifier les points de modification et structurer les évolutions devient un enjeu central. Réduire le nombre d’actions répétitives, éviter de recharger ou de retraiter inutilement des rapports lourds, et propager les changements de manière cohérente permet de faire gagner un temps considérable aux équipes data, tout en améliorant la fiabilité globale.

C’est précisément à ce moment-là que la question de l’industrialisation de la BI se pose, et que l’IA, lorsqu’elle s’appuie sur un cadre clair et centralisé, devient un levier concret pour réduire la charge opérationnelle des équipes data.

L’IA en BI : un levier d’industrialisation

Contrairement à certaines idées reçues, l’IA ne consiste pas à “laisser la machine décider”. Dans un contexte BI, elle intervient surtout comme un outil d’assistance intelligente, capable d’exploiter un cadre existant pour accélérer et sécuriser le travail des équipes data.

Pour être efficace, l’IA doit s’appuyer sur :

un modèle sémantique clair,

des règles métier explicites,

une architecture BI structurée.

Sans ces fondations, l’IA produit au mieux des résultats approximatifs, au pire des erreurs difficilement détectables. En revanche, lorsqu’elle est intégrée dans une démarche méthodique, elle devient un véritable levier de montée en maturité.

Méthode : faire évoluer Power BI vers une BI plus structurée

De fichiers PBIX isolés à une logique projet

Les méthodes décrites ci-dessous ont été explorées lors d’un hackathon organisé pendant un séminaire interne Synako.

L’objectif n’était pas de produire un POC isolé, mais de tester, sur des cas concrets, comment Power BI pouvait être utilisé différemment lorsqu’on change de posture : passer d’un outil de reporting à un véritable système BI industrialisable.

Power BI étant un outil que Synako utilise également dans ses projets clients, ces travaux ont été menés avec une double exigence : faisabilité technique et applicabilité concrète en contexte entreprise.

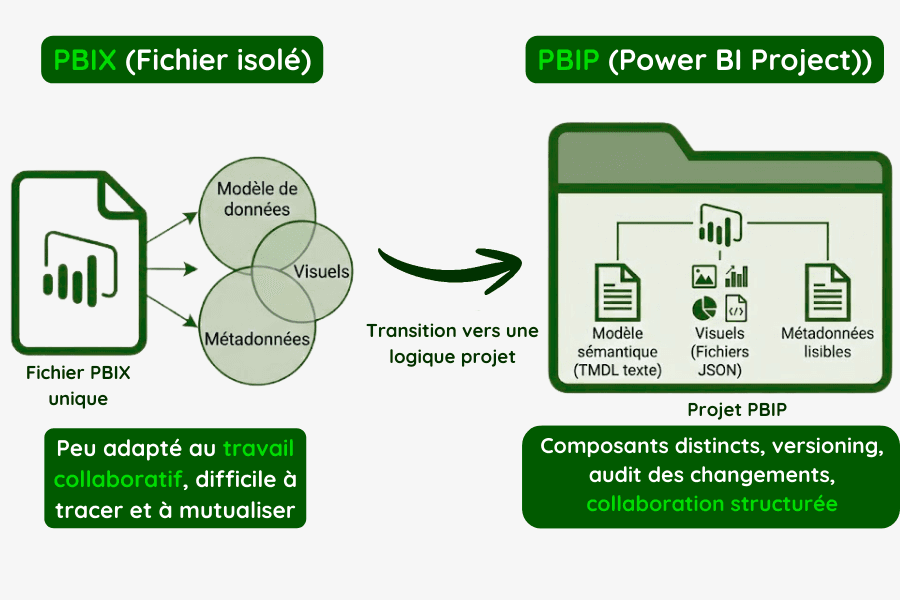

Historiquement, Power BI repose sur des fichiers PBIX : un format pratique, mais peu adapté au travail collaboratif en équipe. Un fichier unique regroupe à la fois le modèle de données et les visuels, ce qui rend les évolutions difficiles à tracer et à mutualiser.

L’introduction du format PBIP (Power BI Project) marque un changement de paradigme. Power BI -en s’ouvrant à des outils externes non-power-BI- ne se limite plus à un outil de reporting, mais devient un objet data industrialisable, avec des composants distincts :

un modèle sémantique déclaré sous forme de texte au format TMDL

des métadonnées lisibles,

des visuels, séparés de la logique métier, décrits en fichiers JSON.

Cette approche permet d’ouvrir Power BI à des pratiques issues du data engineering : versioning, audit des changements, collaboration structurée.

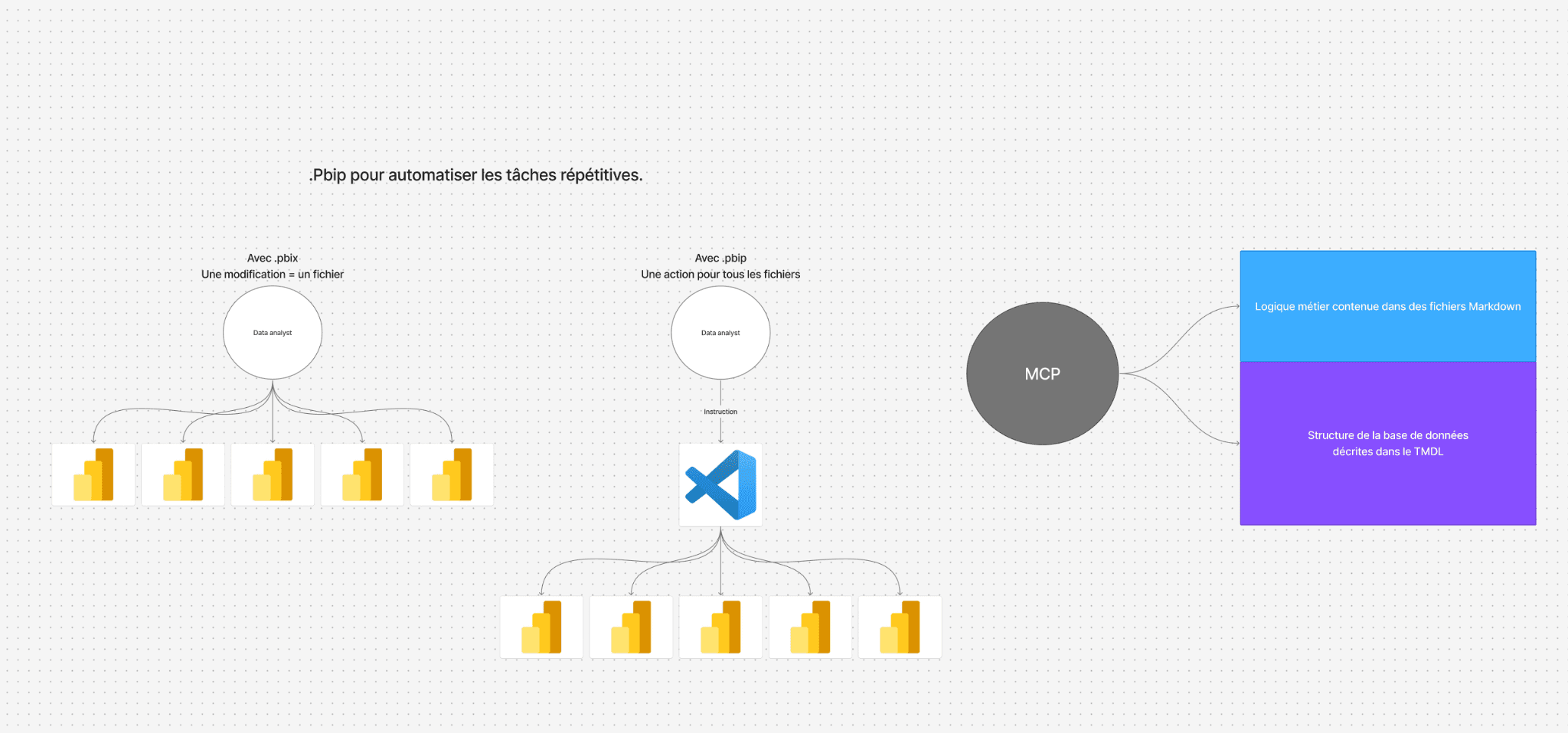

Centraliser les évolutions pour gagner en cohérence

L’un des apports majeurs de cette approche est la centralisation du point d’action. Là où une modification devait auparavant être répétée dans plusieurs fichiers, elle peut désormais être effectuée à un niveau central, puis propagée de manière cohérente à l’ensemble des dashboards concernés.

Ce changement d’échelle est fondamental. On ne travaille plus rapport par rapport, mais à l’échelle d’un système BI. C’est sur cette base que l’IA peut intervenir efficacement.

Voir schéma 👇

Cas d’usage : comment l’IA s’intègre concrètement dans la BI

Automatiser les tâches répétitives à faible valeur ajoutée

Dans un environnement BI structuré, une grande partie du temps des analystes est consacrée à des tâches répétitives : ajuster des règles de calcul, appliquer des conventions de nommage, vérifier des cohérences entre dashboards. Ces tâches, bien que nécessaires, consomment une part significative du temps disponible, au détriment de l’analyse, de la compréhension métier et de la création de valeur.

L’IA peut ici agir comme un assistant technique, capable, en fonction de la qualité du contexte de :

proposer des modifications cohérentes sur plusieurs éléments,

détecter des incohérences avec les conventions et structures du modèle sémantique, en se basant uniquement sur les métadonnées et les règles codées, sans analyser les données brutes

accélérer la mise à jour de modèles existants.

L’objectif n’est pas de déléguer la responsabilité, mais de libérer du temps à vos équipes data pour des tâches à plus forte valeur ajoutée : analyse, échange avec les métiers, amélioration continue des usages.

Quand l’IA s’appuie sur le modèle sémantique : le rôle du MCP Power BI

Lors du hackathon organisé pendant le séminaire Synako, les data analystes ont également exploré une nouvelle brique encore peu visible mais déterminante : l’utilisation du MCP Power BI (Model Context Protocol) comme intermédiaire entre l’IA, le modèle sémantique et les règles métier.

Le MCP n’est pas un outil d’IA Il s’agit d’une couche d’intermédiation qui permet de faire dialoguer l’IA (via Microsoft Copilot) au modèle sémantique Power BI et aux règles métier formalisées.

L’objectif n’était pas d’automatiser des décisions métier, mais de créer un cadre fiable dans lequel l’IA peut intervenir sans dégrader la cohérence du modèle.

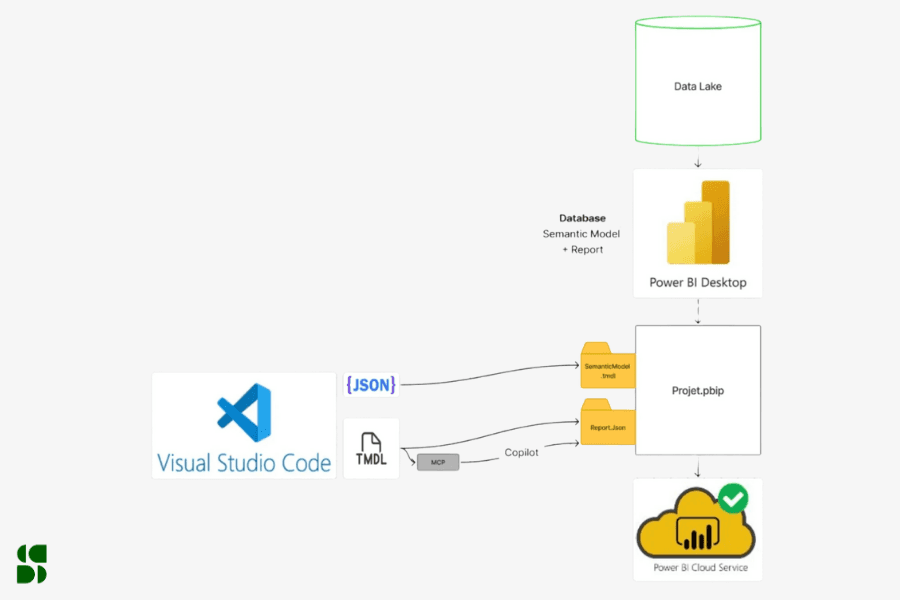

Concrètement, le MCP permet à Microsoft Copilot de raisonner à partir d’un contexte explicitement défini, composé de deux éléments clés :

la structure de la base de données, décrite explicitement dans le modèle sémantique via le TMDL ;

la logique métier, formalisée dans des fichiers Markdown, lisibles, documentés et validés par les équipes.

Ce point est essentiel.

L’IA ne raisonne pas à partir d’intuitions ou de suppositions, mais à partir d’un référentiel clair, maintenu par les data analystes et les métiers.

Pourquoi Visual Studio Code devient un point d’entrée clé

Il ne s’agit pas ici d’un simple éditeur de code, mais d’un environnement de travail unifié permettant d’orchestrer directement les composants internes d’un projet Power BI.

Les data analystes y accèdent :

aux fichiers TMDL, qui décrivent la structure du modèle sémantique,

aux fichiers JSON, qui définissent les rapports et leurs paramètres,

aux fichiers Markdown, qui documentent la logique métier et les règles de calcul.

Le MCP agit alors comme une couche d’orchestration entre ces fichiers et l’IA.

Microsoft Copilot peut proposer, générer ou ajuster des évolutions en s’appuyant sur le modèle existant, plutôt que de l’inférer à partir d’un échantillonqu’en le contournant ou en le recréant. Cette approche permet de réduire drastiquement le temps nécessaire aux évolutions courantes, tout en limitant les erreurs liées aux modifications manuelles et aux oublis de propagation entre rapports.

Une IA d’assistance, pas de substitution

L’objectif n’est donc pas d’automatiser la décision métier, mais de sécuriser et accélérer les évolutions du modèle, tout en conservant un contrôle humain strict sur :

les règles de calcul,

la sémantique,

les impacts globaux sur les tableaux de bord.

Cette expérimentation illustre une évolution majeure de la Business Intelligence :

l’IA devient un outil d’assistance au data analyste, capable de réduire les tâches répétitives et d’améliorer la cohérence globale, à condition que le socle data soit propre, structuré et documenté.

Donner de l’intelligence métier aux évolutions BI

Un autre apport clé de l’IA réside dans sa capacité à exploiter un référentiel métier formalisé. Lorsque les règles de gestion, les définitions d’indicateurs et les conventions analytiques sont clairement documentées, l’IA peut s’appuyer sur ce cadre pour proposer des évolutions alignées avec les usages réels.

Cette logique se rapproche de celle des notebooks documentés : la BI ne devient pas seulement un ensemble de chiffres, mais un système explicable, lisible et partageable entre équipes techniques et métiers.

Faciliter la collaboration entre analystes et outils

L’IA joue également un rôle d’interface. Elle permet de dialoguer plus facilement avec des environnements complexes, notamment lorsque les composants BI deviennent accessibles sous forme de fichiers lisibles et versionnables.

Dans ce cadre, l’IA ne remplace pas les analystes, mais fluidifie l’interaction entre humains et systèmes, en accélérant l’exploration, la compréhension et l’évolution des modèles existants.

Quels bénéfices concrets pour une entreprise ?

Adoptée dans une démarche structurée, l’IA appliquée à la BI permet :

une meilleure cohérence entre dashboards,

une réduction significative des erreurs liées aux modifications manuelles,

un gain de temps sur les tâches répétitives,

une BI plus lisible et plus gouvernable,

une capacité accrue à faire évoluer les usages sans refonte permanente.

À terme, la BI cesse d’être un empilement de rapports pour devenir un véritable produit interne, capable de s’adapter à la croissance et aux nouveaux besoins métiers.

À l’échelle de l’entreprise, ces bénéfices se traduisent par des cycles d’évolution plus court, une meilleure réactivité face aux demandes métier et une réduction de la dépendance à quelques profils experts, souvent très sollicités.

Les mots de Bastien et Nour, Data analystes chez Synako :

Bastien : “Avec le format PBIP jumelé à VS Code et Copilot, les règles métier peuvent être centralisées pour tous les dashboards, ce qui fait gagner un temps précieux à chaque évolution. Les agents IA nous permettent aussi de générer automatiquement des fichiers de documentation, garantissant cohérence et partage entre équipes data et métiers.”

Nour : “Les projets BI répondent au besoin client. Le data analyste ne cherche pas à produire le rendu parfait, mais à itérer efficacement à l'aide d'une stack technique appropriée et d'une connaissance solide des règles métier."

Avec des contrôles centralisés et la perspective d'un assistant IA, la boîte à outils que présente cet article s'inscrit directement dans une quête d'efficacité :

Augmenter la rapidité et la qualité dans les itérations en écartant les tâches les plus chronophages

Favoriser le dialogue avec les équipes dont émerge le besoin

Se consacrer à la connaissance métier pour valoriser les intuitions qui en découlent.”

Ce que cette approche change dans la relation à la donnée

L’apport principal de l’IA en Business Intelligence n’est pas technologique, mais organisationnel. Elle encourage les entreprises à clarifier leurs règles, à structurer leurs modèles et à repenser la manière dont la donnée est produite, maintenue et exploitée.

En ce sens, l’IA agit comme un révélateur de maturité : elle fonctionne d’autant mieux quand la BI est pensée comme un système cohérent, et non comme une succession de livrables indépendants.

Conclusion : une BI plus intelligente, mais surtout plus maîtrisée

L’intelligence artificielle ne transforme pas la Business Intelligence. Elle en amplifie les bénéfices lorsqu’elle est intégrée dans une démarche méthodique, structurée et gouvernée.

En combinant un modèle sémantique clair, des règles métier explicites et des usages IA ciblés, il devient possible de gagner du temps sur les tâches répétitives, de sécuriser les évolutions et de rendre la BI plus robuste dans la durée.

Chez Synako, cette approche s’inscrit dans une vision claire : construire des systèmes de Business Intelligence durables, évolutifs et alignés avec les usages réels, tout en restant compréhensibles, gouvernables et sources de valeur pour les équipes métiers comme pour les équipes data.