Logiciel métier

Tests fonctionnels automatisés par l’IA : méthodes, limites et bonnes pratiques

3 février 2026

7

min de lecture

Sommaire

Introduction

Les tests de régression front-end sont indispensables pour garantir la qualité d’une application web. Ils permettent de vérifier qu’une nouvelle évolution n’a pas cassé une fonctionnalité existante : un parcours client, une commande, un contrat, un accès sécurisé.

Dans la pratique, ces tests sont souvent complexes à maintenir. Plus une interface évolue, plus les tests deviennent fragiles, coûteux et difficiles à faire durer dans le temps.

Lors d’un séminaire Synako, un hackathon interne a permis d’explorer une question très concrète :

Comment utiliser l’intelligence artificielle pour automatiser les tests front-end, sans tomber dans une approche instable ou “magique” ?

L’objectif n’était pas de remplacer les outils existants, ni de “mettre de l’IA partout”, mais de confronter les promesses de l’IA à la réalité du terrain :

documentation déjà existante,

contraintes techniques,

besoin de fiabilité,

exigence de pérennité.

Cet article revient sur cette expérimentation et partage une approche pragmatique des tests de régression front-end via l’IA, pensée pour rester robuste, compréhensible et réellement exploitable en production.

Pourquoi les tests de régression front-end sont difficiles à automatiser

Les tests front-end portent sur des parcours critiques : créer une commande, accéder à un contrat, filtrer une liste, naviguer dans une interface.

Mais plusieurs difficultés reviennent systématiquement :

les interfaces évoluent fréquemment,

les éléments à l’écran changent de position ou de libellé,

les données affichées sont dynamiques,

de simples ajustements visuels peuvent casser un test,

les scripts deviennent difficiles à lire pour les profils non techniques.

Résultat :

les tests deviennent fragiles, génèrent de faux positifs, et finissent parfois par être désactivés ou ignorés.

C’est dans ce contexte que l’IA est souvent présentée comme une solution miracle. Mais la réalité est plus nuancée.

Automatiser les tests avec l’IA : promesse ou illusion ?

Lors du hackathon, plusieurs outils d’automatisation de tests basés sur l’IA ont été explorés.

Le principe est séduisant :

“L’IA regarde l’écran, comprend ce qu’il faut faire, clique à votre place et valide le résultat.”

Dans les faits, plusieurs limites sont rapidement apparues :

les résultats ne sont pas toujours reproductibles,

un même test peut passer un jour et échouer le lendemain,

l’IA interprète parfois mal l’intention fonctionnelle,

la consommation de ressources (tokens) peut exploser

il est difficile de garantir la pérennité des tests.

L’IA peut aider, mais elle ne suffit pas à elle seule.

Pour être réellement utile, elle doit s’inscrire dans une architecture claire, avec des règles précises et un contrôle humain permanent.

Partir de l’existant : documentation et collaboration PM / dev

Un enseignement clé de l’expérimentation Synako :

l’automatisation ne doit pas repartir de zéro.

Les équipes se sont appuyées sur :

le cahier de recette existant,

les scénarios définis par les Product Managers,

l’expertise des développeurs pour l’outillage et l’exécution.

Cette collaboration est centrale :

le PM décrit les parcours fonctionnels et les règles métier,

le développeur fournit l’infrastructure technique,

les tests restent lisibles, compréhensibles et modifiables.

L’IA vient accélérer, pas remplacer, ce travail commun.

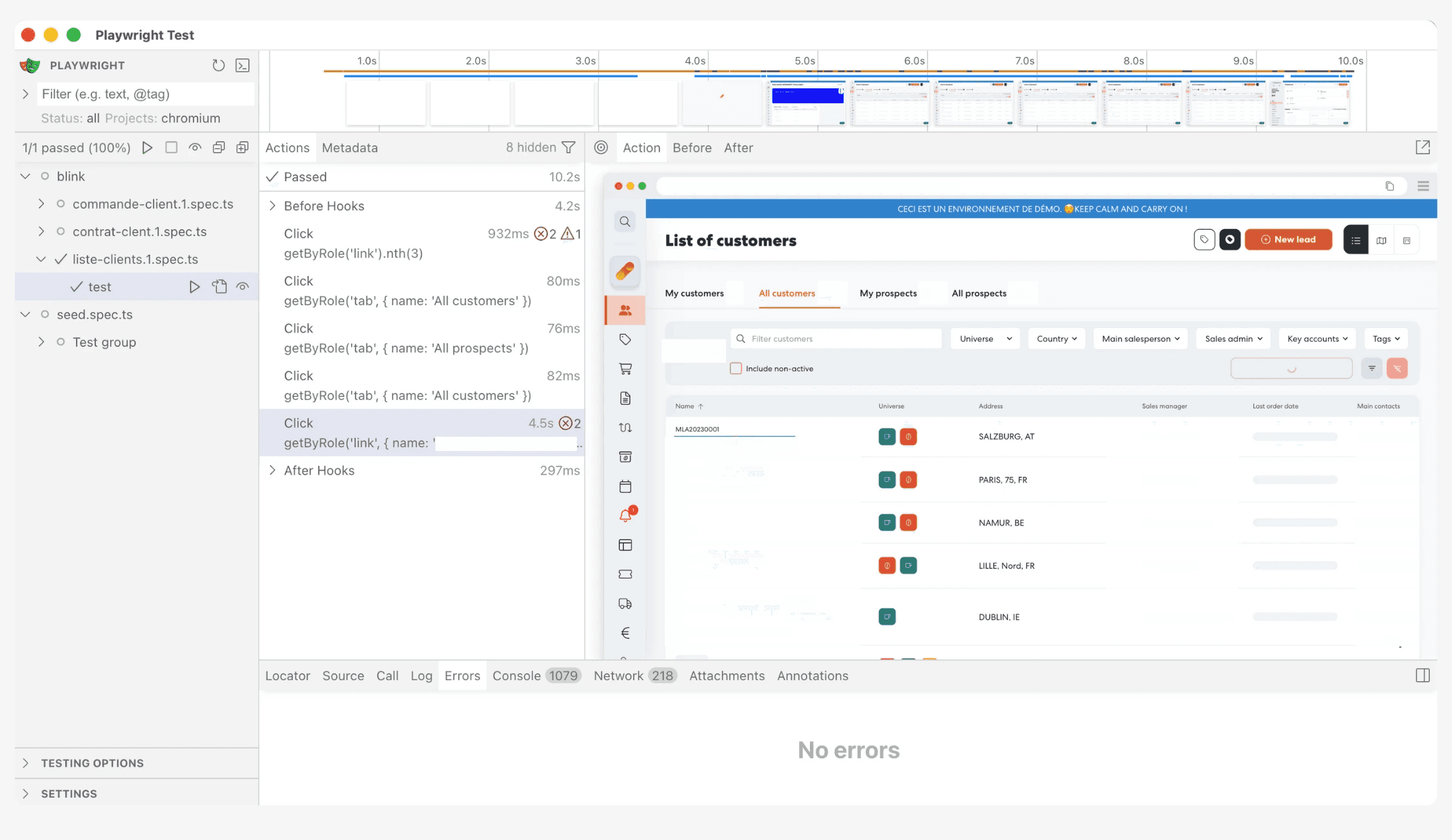

Une approche hybride : IA + Playwright

Plutôt que de confier l’ensemble des tests à l’IA, Synako a exploré une approche hybride reposant sur Playwright, un framework de tests front-end éprouvé.

Playwright permet :

d’exécuter des tests sur plusieurs navigateurs,

de simuler des usages mobiles via émulation,

de produire des scripts explicites, versionnables et maintenables.

Le rôle de l’IA dans cette approche

L’IA n’exécute pas directement les tests en production. Elle intervient comme assistant :

aide à générer des scénarios de test,

accélère la création des scripts,

facilite l’exploration de l’interface,

propose une première base de travail.

Les tests finaux restent du code classique, lisible, contrôlé et exécutable de manière déterministe.

La clé de la fiabilité : des sélecteurs stables

Un point critique identifié lors du hackathon concerne la manière de cibler les éléments de l’interface.

Les équipes ont constaté que :

les sélecteurs basés sur le texte ou la position sont fragiles,

un simple changement de libellé peut casser un test,

les faux positifs deviennent fréquents.

La solution retenue :

utiliser des identifiants techniques stables (data-test-id) intégrés directement dans le code.

Un script a été envisagé pour :

remplacer automatiquement les sélecteurs instables,

renforcer la robustesse des tests,

limiter les échecs liés à des changements visuels mineurs.

Gérer l’authentification et les sessions de test

Autre sujet clé : l’authentification.

Rejouer un parcours complet de connexion à chaque test :

rallonge les temps d’exécution,

fragilise les scénarios,

complique la maintenance.

La solution explorée repose sur :

une API sécurisée permettant de récupérer une session utilisateur valide,

un usage strictement limité à la sandbox,

des permissions contrôlées.

Les tests deviennent plus rapides, plus fiables et plus proches des usages réels.

Pourquoi l’IA doit rester encadrée

Un principe fort est ressorti du hackathon :

l’IA ne doit jamais agir sans cadre.

Les équipes ont posé plusieurs règles claires :

pas d’accès libre aux actions critiques,

pas de décisions implicites,

pas d’automatisation aveugle.

Les tests doivent rester :

visibles,

auditables,

reproductibles,

compréhensibles par les équipes produit et techniques.

L’IA devient une interface intelligente, pas un substitut aux processus existants.

Quels bénéfices concrets pour les équipes ?

Pour les équipes produit (PM)

des tests plus lisibles,

une meilleure appropriation de la qualité,

une collaboration renforcée avec les développeurs.

Pour les équipes techniques

des tests plus stables dans le temps,

moins de faux positifs,

une maintenance réduite,

une automatisation réellement exploitable en CI/CD.

Pour l’entreprise

des mises en production plus sécurisées,

moins de régressions,

une meilleure qualité perçue par les utilisateurs.

Ce que révèle cette expérimentation

Ce hackathon a mis en évidence une réalité essentielle :

L’IA n’est pas le sujet central. L’architecture l’est.

Sans :

documentation claire,

conventions stables,

collaboration PM / dev,

outillage adapté,

l’IA amplifie les problèmes au lieu de les résoudre.

Conclusion : automatiser intelligemment, pas aveuglément

Les tests de régression front-end via l’IA ne sont ni une révolution magique, ni un gadget marketing. Ils deviennent réellement utiles lorsqu’ils s’intègrent dans une démarche structurée, pragmatique et maîtrisée.

Chez Synako, cette expérimentation s’inscrit dans une vision claire :

outiller les équipes sans les déposséder,

automatiser sans perdre en fiabilité,

utiliser l’IA comme levier, pas comme béquille.

L’enjeu n’est pas de faire “plus d’IA”, mais de faire mieux, durablement.